Explora como una IA entiende tus palabras

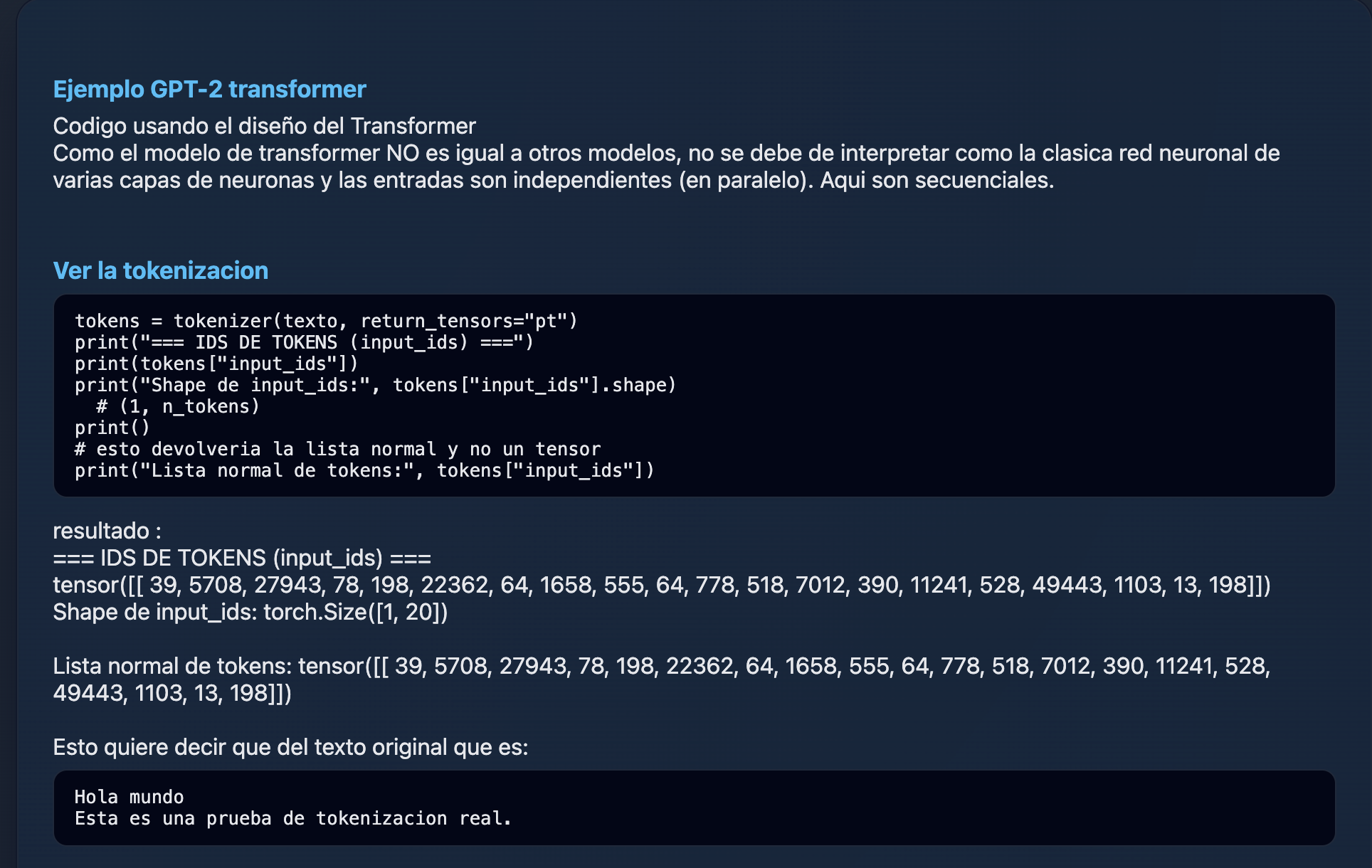

Esta pagina reune demos, dibujos, videos, audios y explicaciones para que entiendas paso a paso que hace un modelo como GPT-2 cuando le escribes una frase. Empieza con lo visual y sencillo, y si quieres baja hasta la parte avanzada para ver el detalle tecnico.